Hacia 1950, un escritor de ciencia ficción proponía 3 leyes para regir el comportamiento de los robots. Era Isaac Asimov, quien por medio de una serie de cuentos recopilados en un libro titulado “Yo Robot”, inauguraba también la palabra robótica mientras ponía a prueba una y otra vez a sus robots a través de diferentes aventuras.

En la actualidad, los robots existen a una proporción de 5 por cada 100 trabajadores en países como Corea del Sur, y cada vez están más presentes en los hogares con propuestas que van desde los robots de limpieza hasta los androides con fines sexuales… con polémica incluida.

Sin embargo, ¿se aplican las leyes de la robótica de Asimov a los robots actuales?

Tabla de Contenidos

Leyes de la robótica de Isaac Asimov

Las Leyes de la robótica de Isaac Asimov constituyen el centro de las operaciones de todo robot, y están insertas en el código de su sistema operativo desde su fabricación. No se puede concebir un robot quebrantando alguna de estas normas, pues haría cortocircuito y quedaría inutilizado.

1. Un robot no puede hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

La primera ley de la robótica es el alma de los temores humanos: crear algo que termine por destruirlo. Los robots de Isaac Asimov son tan complejos y poderosos que de no existir esta norma se rebelarían a la primera oportunidad.

Los robots de Asimov están dotados de consciencia, por medio de un cerebro positrónico –un dispositivo fabricado de platino e iridio- y la orden de cuidar la vida de los seres humanos a toda costa los mantiene como sirvientes dóciles que ayudan a las personas en todo tipo de tareas.

2. Un robot debe obedecer las órdenes dadas por los seres humanos, excepto si estas órdenes entrasen en conflicto con la Primera Ley.

Los robots deben ser obedientes, pero no puede ordenárseles que ataquen a otro ser humano. Los robots no son armas de guerra, ni pueden utilizarse con fines de dominación. Además, según los libros de Asimov, todos los androides continúan perteneciendo a la empresa fabricante, por lo que no pueden dedicarse a otros usos más allá de los previstos.

3. Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la Primera o la Segunda Ley.

Los robots deben ser capaces de cuidarse a sí mismos y de no ponerse en peligro. Sin embargo, si un humano está en una situación que pueda dañar su vida, el robot está obligado a rescatarlo, aunque eso pueda implicar el sacrificio del robot.

¿Son aplicables las leyes de Asimov en la vida real?

El mundo actual tiene prioridades diferentes al de los libros de Isaac Asimov. Para empezar, muchos de avances tecnológicos se desarrollan en el ámbito de la guerra, o como un arma. La DARPA, que es la Agencia de Proyectos de Investigación Avanzados de Defensa de Estados Unidos, está creando algunos de los robots más impresionantes, pero podrían tener aplicaciones de guerra.

Adicionalmente, implantar en un robot la Primera Ley de Asimov ha ocasionado que estas máquinas no sepan cómo actuar. El investigador Alan Winfield programó a una serie de robots para que tratara de salvar a otros –como si fueran personas- y no cayeran a un hipotético precipicio.

¿El resultado? Cuando dos o más robots “humanos” se dirigían al peligro, el robot no podía salvarlos a todos y en 14 de las 33 pruebas realizadas la máquina se quedó paralizada, indecisa por el dilema ético planeado.

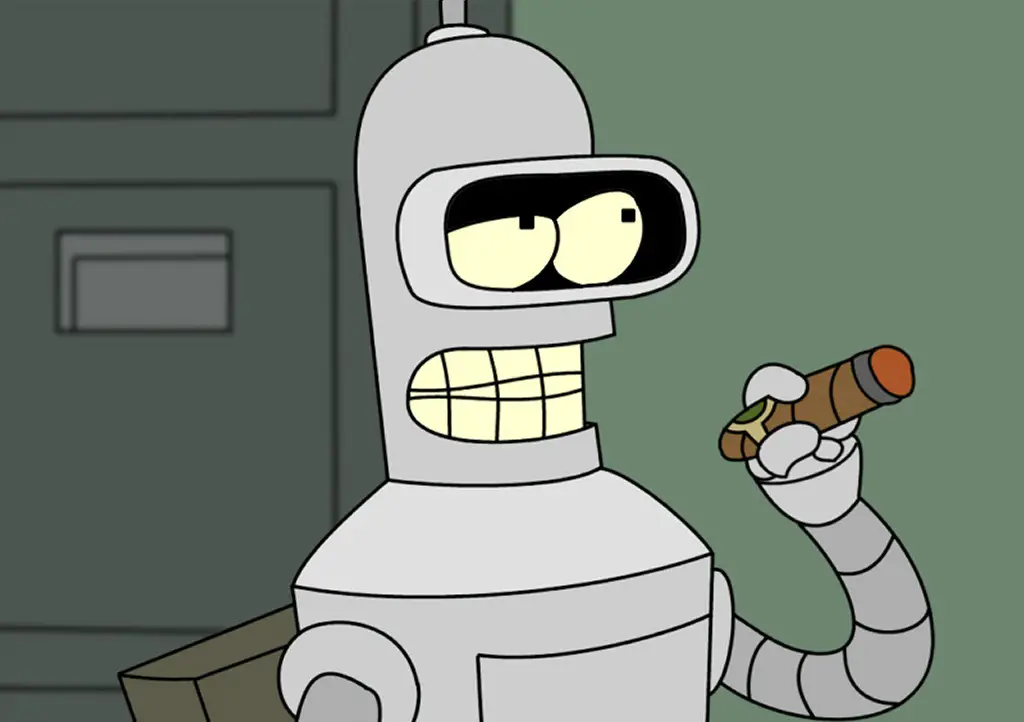

Aplicar las leyes de Isaac Asimov en los robots actuales es impráctico, en primera porque no tienen el nivel de inteligencia que los imaginados por el escritor y en segunda porque sus aplicaciones, más allá de crear miles de robots con forma y personalidad humana, van más encaminadas a ser máquinas de trabajo: brazos fuertes en las fábricas ensambladoras o dedos hábiles para realizar operaciones repetitivas.

Las nuevas 5 Leyes de la robótica

En septiembre de 2010, el Consejo de Investigación de Ingeniería y Ciencias Físicas, junto con el Consejo de Investigación de Artes y Humanidades de Inglaterra se reunieron para discutir sobre robots y las leyes de Asimov sobre su comportamiento.

“Las leyes de Asimov son inapropiadas porque intentan insistir que los robots se comportan en ciertas maneras, como si fueran personas, cuando en la vida real, son los humanos que diseñan y usan los robots los que deben ser los actuales sujetos de cualquier ley”, declararon en aquel momento.

Además de eso, propusieron 5 leyes de la robótica recomendadas para todo creador de robots.

1. Los robots no deben ser diseñados exclusivamente o principalmente para matar o dañar humanos.

Esta ley tiene indica que los robots son herramientas multipropósito, pero uno de ellos no es hacer atacar a otras personas. Todo bien, según Asimov, salvo que permite que los robots sean utilizados como armas en casos de seguridad nacional.

“Permitimos que los granjeros utilicen armas para matar plagas pero utilizarlos para matar personas es claramente malo”, dicen las normas. “Esta ley, si es adoptada, limita las capacidades comerciales de los robots, pero visto como un principio es esencial para su aceptación segura en la sociedad civil”.

2, Los seres humanos son los responsables, no los robots. Ellos son herramientas diseñadas para cumplir con los objetivos de los humanos, pero también con las leyes existentes.

No se puede crear un robot que sirva para romper la ley. En este sentido, que un robot asesine a una persona no es culpa de la máquina, sino del humano que lo utilice para tal fin, como sería un cuchillo o una pistola.

También se integran apartados como la privacidad, y que la información que recolecte sea utilizada sólo para los fines que se establezcan, y que además sea mantenida a salvo.

3. Los robots deben ser diseñados de tal forma que aseguren su protección y seguridad.

Los robots, como piezas de tecnología, son caros. Por ello deben desarrollarse bajo condiciones de seguridad, y si los robots también son seguros, eso facilitará su adopción en la sociedad. Una versión adaptada de la Tercera Ley de Asimov.

4. Los robots son objetos, no deben ser diseñados para evocar una respuesta emocional. Siempre debe ser posible diferenciar a un robot de un ser humano.

Los robots son máquinas, y no deben sentir emociones. Al menos eso recomienda la EPSRC, porque la “lovótica” –love-robotica- se postula ya como una de las grandes áreas del futuro de los robots. No sólo robots con fines sexuales, sino máquinas capaces de expresar amor y de emular muchos de los sentimientos humanos.

5. Debe ser siempre posible averiguar quién es el responsable y dueño legal del robot.

“Un robot nunca será legalmente responsable de nada. Es un objeto”, dice la quinta norma de robótica propuesta por la EPRSC. Por eso, ante cualquier malfuncionamiento o situación que cause algún perjuicio a terceros, siempre debe ser posible identificar al humano responsable de su creación o a su dueño legal.

¿Cuáles normas crees que deban cumplirse en la robótica? Déjanos tu opinión en los comentarios.